[Graph] 12/10 간단하게 알아보는 GAT(Graph Attention Network)

[Graph] 12/10 간단하게 알아보는 GAT(Graph Attention Network)

paper Graph Attention Networks We present graph attention networks (GATs), novel neural network architectures that operate on graph-structured data, leveraging masked self-attentional layers to address the shortcomings of prior methods based on graph convolutions or their approximations arxiv.org 연구의 필요성 CNN 은 image classification ,segmentation 및 machine translation 에 좋은 성능을 보여줌. 이러한 data는 grid와..

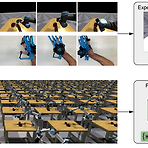

강화학습 논문 정리 15편 : Accelerating Interactive Human-like Manipulation Learning with GPU-based Simulation and High-quality Demonstrations (IEEE-RAS 2022)

강화학습 논문 정리 15편 : Accelerating Interactive Human-like Manipulation Learning with GPU-based Simulation and High-quality Demonstrations (IEEE-RAS 2022)

작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB) Keywords : Dexterous manipulation, Learning from human demonstrations, Reinforcement Learning 논문 링크 : https://ieeexplore.ieee.org/document/10000161 Accelerating Interactive Human-like Manipulation Learning with GPU-based Simulation and High-quality Demonstrations Dexterous manipulation with anthropomorphic robot hands remains a challenging problem in robot..

강화학습 논문 정리 14편 : DexMV : Imitation Learning for Dexterous Manipulation from Human Videos (ECCV 2022)

강화학습 논문 정리 14편 : DexMV : Imitation Learning for Dexterous Manipulation from Human Videos (ECCV 2022)

작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB) Keywords : Dexterous manipulation, Learning from human demonstrations, Reinforcement Learning 논문 링크 : https://link.springer.com/chapter/10.1007/978-3-031-19842-7_33 홈페이지 링크 : https://yzqin.github.io/dexmv/ DexMV: Imitation Learning for Dexterous Manipulation from Human Videos yzqin.github.io 영상 링크 : https://www.youtube.com/watch?v=scN4-KPhJe8 깃헙 링크 : https..

강화학습 논문 정리 13편 : Skill Preferences : Learning to Extract and Execute Robot Skills from Human Feedback 논문 리뷰 (CoRL 2021)

강화학습 논문 정리 13편 : Skill Preferences : Learning to Extract and Execute Robot Skills from Human Feedback 논문 리뷰 (CoRL 2021)

작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB) Keywords : Reinforcement Learning, Skill Extraction, Human Preferences 논문 링크 : https://proceedings.mlr.press/v164/wang22g.html Skill Preferences: Learning to Extract and Execute Robotic Skills from Human Feedback A promising approach to solving challenging long-horizon tasks has been to extract behavior priors (skills) by fitting generative models to large..

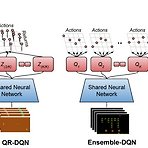

강화학습 논문 정리 12편 : An Optimistic Perspective on Offline Reinforcement Learning 논문 리뷰 (ICML 2020)

강화학습 논문 정리 12편 : An Optimistic Perspective on Offline Reinforcement Learning 논문 리뷰 (ICML 2020)

작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB) 논문 링크 : https://proceedings.mlr.press/v119/agarwal20c.html An Optimistic Perspective on Offline Reinforcement Learning Off-policy reinforcement learning (RL) using a fixed offline dataset of logged interactions is an important consideration in real world applications. This paper studies offline RL using the DQN rep... proceedings.mlr.press 홈페이지 링크 : https:..

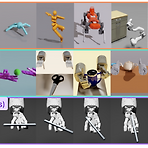

강화학습 논문 정리 11편 : Eureka: Human-Level Reward Design via Coding Large Language Models 논문 리뷰 (arXiv 2023)

강화학습 논문 정리 11편 : Eureka: Human-Level Reward Design via Coding Large Language Models 논문 리뷰 (arXiv 2023)

작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB) 논문 링크 : https://arxiv.org/abs/2310.12931 Eureka: Human-Level Reward Design via Coding Large Language Models Large Language Models (LLMs) have excelled as high-level semantic planners for sequential decision-making tasks. However, harnessing them to learn complex low-level manipulation tasks, such as dexterous pen spinning, remains an open problem. We bridg..

강화학습 논문 정리 10편 : A workflow for Offline Model-Free Robotic Reinforcement Learning 논문 리뷰 (CoRL 2022)

강화학습 논문 정리 10편 : A workflow for Offline Model-Free Robotic Reinforcement Learning 논문 리뷰 (CoRL 2022)

작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB) 논문 링크 : https://proceedings.mlr.press/v164/kumar22a.html A Workflow for Offline Model-Free Robotic Reinforcement Learning Offline reinforcement learning (RL) enables learning control policies by utilizing only prior experience, without any online interaction. This can allow robots to acquire generalizable skills from ... proceedings.mlr.press 홈페이지 링크 : Off..

[논문리뷰] Deformable object manipulation :: Modeling 파트

[논문리뷰] Deformable object manipulation :: Modeling 파트

Modeling, learning, perception, and control methods for deformable object manipulation 저자 : Hang Yin, Anastasia Varava, Danica Kragic 논문 : https://www.science.org/doi/epdf/10.1126/scirobotics.abd8803 작성 : 이해구 다양한 물체가 단순 강체가 아닌 힘(중력포함)에 따라 쉽게 변할 수 있다. 이런 물체들을 다루는 것은 분명 다양한 어플리케이션에 필요하지만 여러 분야들이 통합되어야지만 잘 될 수 있어 강체를 다루는 것보다 적게 연구되었었다. 다양한 분야가 발전하면서 기존에 제약을 해결할 인사이트를 제공해주고 있다. 논문에서는 변형 가능한 물체에 ..