티스토리 뷰

강화학습 논문 정리 9편 : DR3 : Value-Based Deep Reinforcement Learning Requires Explicit Regularization 논문 리뷰 (ICLR 2022)

hanyangrobot 2023. 9. 17. 20:39작성자 : 한양대학원 인공지능융합학과 유승환 박사과정 (CAI LAB)

안녕하세요!! 정말 오랜만의 블로그 포스팅입니다 ㅎㅎ 요새는 Offline Reinforcement Learning 분야를 연구하고 있습니다! 그런데 요녀석이 학습이 생각보다 잘 안돼더라고요 ㅜㅜ 저와 비슷한 고민을 하는 분들을 위해 오프라인 강화학습을 위한 팁! 논문을 가져왔습니다 ㅎㅎ 재밌게 읽어봐주세요~!

논문 링크 : https://openreview.net/forum?id=POvMvLi91f

DR3: Value-Based Deep Reinforcement Learning Requires Explicit...

Despite overparameterization, deep networks trained via supervised learning are surprisingly easy to optimize and exhibit excellent generalization. One hypothesis to explain this is that...

openreview.net

발표 영상 링크 : https://www.youtube.com/watch?v=P7bygduR4hc

논문 저자

Aviral Kumar (1, 2)

https://scholar.google.com/citations?user=zBUwaGkAAAAJ&hl=ko&oi=ao

Aviral Kumar

UC Berkeley - 인용 횟수 5,692번 - Machine Learning - Reinforcement Learning

scholar.google.com

Rishabbh Agarwal (2, 3)

https://scholar.google.com/citations?user=aH8AJu4AAAAJ&hl=ko&oi=ao

Rishabh Agarwal

Senior Research Scientist, Google Brain - 인용 횟수 1,764번 - Reinforcement Learning - Deep Learning - Machine Learning - Artificial Intelligence

scholar.google.com

Tengyu Ma (4)

https://scholar.google.com/citations?user=i38QlUwAAAAJ&hl=ko&oi=ao

Tengyu MA

Stanford University - 인용 횟수 14,442번 - Machine Learning - Deep Learning Theory - Machine Learning Theory

scholar.google.com

Aaron Courville (3)

https://scholar.google.com/citations?user=km6CP8cAAAAJ&hl=ko&oi=ao

Aaron Courville

Professor, DIRO, Université de Montréal, Mila, Cifar CAI chair - 인용 횟수 212,734번 - Machine learning - Artificial Intelligence

scholar.google.com

George Tucker (2)

https://scholar.google.com/citations?user=-gJkPHIAAAAJ&hl=ko&oi=ao

George Tucker

Google Brain - 인용 횟수 14,628번 - Reinforcement Learning

scholar.google.com

Sergey Levine (1, 2)

https://scholar.google.com/citations?user=8R35rCwAAAAJ&hl=ko&oi=ao

Sergey Levine

UC Berkeley, Google - 인용 횟수 107,792번 - Machine Learning - Robotics - Reinforcement Learning

scholar.google.com

(1) UC-Berkeley

(2) Google Research

(3) MILA

(4) Standford University

Abstract

(1) 지도학습의 성과

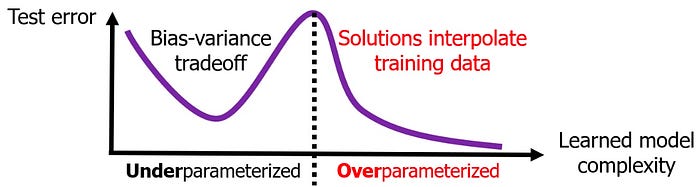

- 심층 신경망의 over-parameterization에도 불구하고, 지도 학습을 통해 학습된 심층 신경망은 최적화하기 쉽고 뛰어난 일반화 성능을 보여주고 있음.

- over-parameterization이란? : 딥러닝 모델이 학습할 때 사용되는 매개변수(가중치 및 편향)의 수가 모델의 복잡도에 비해 상대적으로 많을 때 발생하는 현상.

- 위 현상을 설명하기 위한 가설 중 하나 : implicit regularization의 benefits(일반화 능력)을 심층 신경망이 누림. 이는 테스트 데이터에서 잘 일반화되는 간결한 해결책을 선호하는 Stochastic Gradient Descent에 의해 유도된다고 할 수 있음. (아래의 '이중 감쇠 효과' 그림 참고)

- Implicit Regularization : 모델의 학습 과정에서 자연스럽게 발생하는 정규화 기법 (e.g. Stochastic Gradient Descent, Drop Out, Early Stopping 등)

- Explicit Regularization : 모델의 복잡성을 줄이고 과적합을 방지하기 위해 명시적으로 추가되는 정규화 항목 (e.g. L1 정규화, L2 정규화 등)

(2) Implicit Regularization을 오프라인 강화학습에 적용하면, 지도학습 처럼 좋은 성과를 보일까?

- 오프라인 강화학습은 그렇게 녹록지 않다!! 지도학습에서 관찰되는 Stochastic Gradient Descent의 implict regularization 효과가 오프라인 강화학습 환경에서는 해로울 수 있다!! 이로 인해 오프라인 강화학습의 일반화 성능이 하락되고, 비정상적인 특징 표현을 야기할 수 있음.

- 본문의 이론적 분석 : 기존의 implicit regularization이 시간차 학습에 적용될 때, 결과적으로 유도되는 regularizer가 과도한 "aliasing"을 선호하는 것을 보여줌. 이는 지도학습과는 엄연히 다른 현상임.

- aliasing이란? : 신경망 모델에서 특정 입력값 또는 상태와 관련된 정보를 잘못 해석하는 현상.

- 본문의 실험적 근거 : 시간차 학습(부트스트래핑)을 통해 학습된 심층 신경망 기반 가치 함수에 의해 학습된 특징 표현이 비정상적으로 됨. 이로 인해 상태-행동 쌍의 표현을 aliasing할 수 있다는 것을 보여줌.

(3) 제안하는 방법 : DR3 Regularizer

- 위와 같은 문제를 해결하기 위해, implicit regularizer의 형태를 유도하고, 이 유도 과정에서 영감을 받아 간단하고 효과적인 explicit regularizer인 DR3 Regularizer를 제안

- DR3는 implicit regularizer의 원치 않는 영향을 상쇄시킴

- DR3와 기존의 오프라인 강화학습 알고리즘과 결합되면, 알고리즘의 성능과 학습 안정성을 크게 향상 시킴

- 이를 Atari 2600 게임, D4RL, robotic manipulation from images 도메인에서 검증함.

1. Introduction

(1) 연구 질문 : 지도학습에서 관찰되는 implicit regularization 효과가 강화학습에도 적용될까?

- 심층 신경망은 수십억 개의 매개 변수를 가지고 있음. 이는 원칙적으로 과적합에 취약한 구조임.

- 그럼에도 불구하고 심층 신경망을 사용한 지도학습이 잘 일반화되는 표현을 학습할 수 있는 비결이 무엇일까?

- 널리 통용되는 의견은 심층 신경망이 다양한 implicit regularization 효과로 인해 일반화되는 간단한 해결책(= 잘 일반화되는 효과적인 표현)을 찾는다는 것임.

- 그렇다면, 심층 신경망을 강화학습에서 사용하면 동일한 이유로 잘 작동이 될까?

(2) 연구 목표 : implicit regularization이 심층 가치 함수의 성능 저하를 유도하는 원인을 분석하고 이에 대한 해결책을 제시하는 것.

- Implicit regularization은 심층 신경망으로 구성된 가치 함수를 학습할 때, poor learned representations을 유발할 수 있음.

- 오프라인 강화학습 환경으로 제한을 함. 왜냐하면 온라인 강화학습은 탐험과 비정상적인 데이터 분포로 인해 confounding effects가 발생함. 이는 실험 결과에 오염을 줄 수 있음.

- 오프라인 강화학습의 심층 가치 함수는 반드시 오프라인 데이터(static dataset of epxerience)에서 학습되어야 함.

- 선행 연구에서 오프라인 심층 강화학습으로 학습된 가치 함수는 결국 성능이 저하된다는 것을 밝힘. 이러한 성능 저하는 value network에서 low-rank features의 출현과 관련이 있음

- 선행 연구 [28] : Implicit Under-Parameterization Inhibits Data-Efficient Deep Reinforcement Learning

- 본 연구 목표는 부트스트래핑 중에 poor representations이 나타나는 근본적인 원인을 이해하고 잠재적인 해결책을 개발하는 것임.

- 이 원인을 이해하기 위해, 시간차 학습으로 심층 가치 함수를 학습할 때 발생하는 implicit regularizer를 특성화 함.

- implicit regularizer의 형태는 시간차 학습이 Bellman backup의 양쪽에 나타나는 상태-행동 튜플의 feature representations을 "공동으로 적응(co-adapt)"시킬 것을 나타냄.

(3) 제안하는 아이디어 : 상태-행동 튜플의 feature representations이 co-adaptation되는 현상을 방지할 수 있는 DR3 Regularizer 기법 제안

- 이론적으로 예측된 aliasing 현상이 실제로는 feature "co-adaptation"으로 나타난다는 것을 보여줌.

- Q-value network에 의해 학습된 연속적인 상태-행동 튜플의 feature들은 그들의 dot-product 측면에서 매우 유사해짐.

- 이는 섹션 3에서 자세하게 언급될 예정

- Q- 값이 over-estimation되지 않더라도 오프라인 강화학습에서 prolonged 학습은 feature co-adaptation의 증가로 인한 성능 저하로 이루어질 수 있음.

- implicit regularization의 결과로 발생하는 co-adaptation 문제를 완화하기 위해, DR3라고 불리는 explicit regularizer를 제안함.

- 이론적으로 유도된 implicit regularizer의 효과를 정확하게 추정하는 것은 계산적으로 어려움.

- 반면에, DR3는 co-adaptation 문제를 완하하는 근사치를 제공함

- 실제로 DR3는 연속적인 상태-행동 쌍의 feature를 그들의 dot-product similarity 측면에서 다르게 정규화하는 것으로 나타남

- 실험적으로 DR3는 feature rank collapse와 같은 이전에 언급된 pathologies을 방지함.

- 또한 실제로 사용되는 기본 오프라인 강화학습 방법에 비해 더 오래 학습할 수 있는 방법을 제공하고 성능을 향상시킴.

(4) 연구의 기여점

- 기여점 1

- 시간차 학습으로 심층 가치 함수를 학습할 때 발생하는 implicit 정규화를 이론적으로 증명함.

- implicit 정규화가 오프라인 심층 강화학습 환경에서 "feature co-adaptation"으로 나타난다는 것을 실험적으로 증명함.

- 기여점 2

- 오프라인 강화학습을 위한 간단하고 효과적인 explict regularizer 기법인 DR3를 제안.

- 이는 부트스트래핑 업데이트에서 나나타는 상태-행동 쌍의 feature 유사성을 최소화 함.

- DR3는 REM, CQL, BRAC 과 같은 기존 오프라인 강화학습 알고리즘과 쉽게 결합될 수 있음.

- 실험 결과 요약

- D4RL 작업에서 약 60%의 성능 향상을 보임

- Atari 2600 게임에서 REM보다 160%, CQL보다 25%의 안정성 향상을 보임

- 이미지 기반 robot manipulations 작업에서 큰 성능 향상을 관찰함

2. Preliminaries

(1) Standard RL

- 강화학습의 목표 : Markov Decision Process에서 long-term discounted reward를 최대화하는 것.

- (S, A, R, P, γ)로 표기할 수 있음

- S : 상태 공간, A : 행동 공간

- R : 보상 함수 R(s, a), P : 상태 전이 확률 P(s'|s, a)

- γ : 감가율 γ ∈ [0, 1)

- 정책 $\pi(a|s)$을 위한 Q 함수 $Q^{\pi}(s, a)$ : 정책 $\pi(a|s)$을 따라서 상태 s에서 행동 a를 수행했을 때 얻을 수 있는 expected sum of discounted rewards.

- $Q(s,a) := R(s,a) + \gamma E_{s'\sim P(\cdot|s,a), a'\sim \pi(\cdot|s')}[Q(s',a')]$

- Q 함수는 파라미터 $\theta$로 구성된 신경망으로 파라미터화되어 있음.

- Standard deep RL은 벨만 방정식을 $Q_{\theta}$를 위한 제곱된 시간차 에러 목표(squared temporal difference(TD) error objective)로 변환함.

- $L_{TD}(\theta) = \sum_{s, a, s' \sim D} ((R(s,a) + \gamma \bar{Q}_{\theta}(s',a')) - Q_{\theta}(s,a))^2$

- 이때 $\bar{Q_{\theta}}$는 target Q-network를 의미함. (동일한 Q 네트워크의 delayed 복제본). 그리고 행동 $a'$는 상태 $s'$에서 target Q-network를 최대화함으로써 계산된 값임.

- 이때 심층 신경망의 penultimate layer의 학습된 features를 다음과 같이 표기함 : $\pi_{\theta}(s,a)$

- 이에 따라 Q 함수의 출력 값을 다음과 같이 표기 가능 : $Q_{\theta}(s,a)=w^{T}\pi(s,a)$. 이때 $w$는 마지막 출력층 레이어의 가중치 파라미터 값.

- penultimate layer란? : 신경망 구조에서 뒤에서 두 번째에 위치한 레이어를 가리킴. penultimate layer의 출력은 고차원의 데이터 표현을 포함하고 있기 때문에, 이를 사용하여 다양한 작업을 수행할 수 있음.

(2) Offline RL

- 오프라인 강화학습 알고리즘은 반드시 주어진 데이터셋 $D={(s_{i}, a_{i}, s'_{i}, r_{i})}$만을 사용하여 정책을 학습해야 함. 이 데이터셋은 activate data collection 없이, 어떠한 behavior policy $\pi_{\beta}(a|s)$에 의해 생성됨.

- 오프라인 강화학습에서 주요 문제점 : learned policy와 behavior policy 간의 distributional shift 문제

- 본 연구의 목표는 시간차 학습에서 implicit regularization의 효과를 연구하는 것임. distributional shift 문제를 해결하는 것이 아님.

- 이에 따라 본 연구의 실험은 기존의 오프라인 강화학습 방법론을 기반으로 작업함.

- CQL(Conservative Q-Learning) : 학습 도중에 잘못된 Q-value에 패널티를 줌.

- REM(Random Ensemble Mixture) : Q-함수의 ensemble을 활용함.

- BRAC(Behavior Regularized Actor Critic) : policy constratins를 적용함

3. Implict Regularization in Deep RL via TD-Learning

(1) 3절 구성 소개

- 3.1절 : co-adaptation 현상에 대한 실험적 증거를 제시 (더 자세한 증거는 부록 A.1에서 확인)

- 3.2절 : implicit regularization을 이론적으로 특성화함. 그리고 이것이 co-adaptation 현상을 어떻게 유도하는지에 대해 논의함.

3.1. Feature Co-Adaptation and How It Relates to Implicit Regularization

(1) 본 섹션의 개요

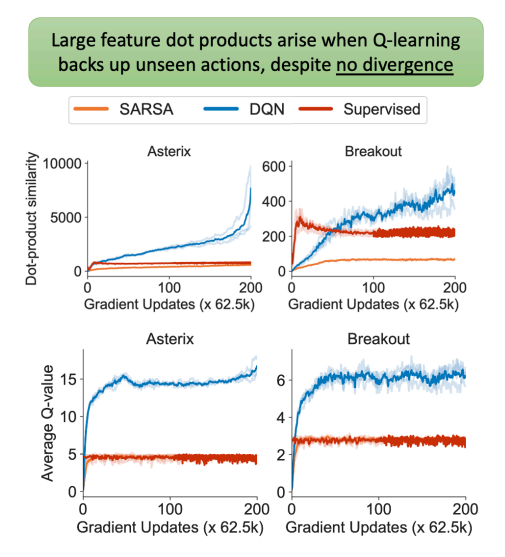

- "Feature co-adaptation" 현상을 실험적으로 제시함. 이 현상은 부트스트래핑을 통해 가치 함수를 학습할 때 발생함. 이 현상으로 인해 연속적인 상태-행동 쌍의 feature representations에서 dot product $\pi(s,a)^{T} \pi(s',a')$ 값이 커지게 됨.

- Feature co-adaptation은 높은 cosine similarity 혹은 높은 feature norms 때문에 발생할 수 있음을 주의해야 함.

- Feature co-adaptation은 feature similarity를 증가시키기 위한 explicit objective가 없더라도 나타남.

(2) Experimental Setup

- 공통점 : 2개의 Atari 게임(Breakout, Seqauest)에서 DQN의 리플레이 버퍼에서 균일하게 샘플링된 데이터의 1%로 이루어진 오프라인 데이터셋을 사용. 아래의 비교 모델을 통해 feature dot products $\pi(s,a)^{T}\pi(s',a')$ 값을 확인함. 또한 데이터셋 전체에 대한 Q-Network의 Average Q-value를 추적하여, 해당 값이 발산하는지 혹은 안정적인지를 측정함.

- 실험 비교 모델 1 : Supervised Regression

- 몬테 카를로 반환 추정치에 대한 지도 회귀를 통해 Q-함수를 학습

- 실험 비교 모델 2 : Offline SARSA

- behavior policy의 가치 $Q^{\pi_{\beta}}$를 추정하는 것이 목표

- 데이터셋 구성 : $(s, a, r, s', a') \in D$. 시간차 학습과 달리, 다음 상태 s'에서 실제로 수행한 행동 a'가 데이터셋에 포함되어 있음.

- 실험 비교 모델 3 : Offline TD-Learning

- behavior policy의 가치 $Q^{\pi_{\beta}}$를 추정하는 것이 목표 (Offline SARSA의 목표와 동일)

- 그러나 다음 상태 s'에서 수행할 행동 a'는 behavior policy $\pi_{\beta}$에 의해 샘플링 됨 : $a' \sim \pi_{\beta}(\cdot|s')$

(3) Observing Feature co-adaptation empirically

- Figure 1 (Right)의 상단 열에 나타낸대로, 시간차 학습을 통해 학습된 DQN(offline TD Learning)은 연속적인 상태-행동 튜플 간의 features에 대한 dot-product의 평균 값이 지속적으로 증가함. 반면에, Supervised Regression은 일정하게 유지되며 작은 값으로 수렴함.

- 이것은 단순히 DQN이 수렴하지 못하는 경우라고 생각할 수 있지만, 아래의 열에서 DQN의 평균 Q-value가 안정된 값으로 수렴되는 것을 보여줌.

- TD error objective에는 이러한 행동을 촉진하는 explicit term이 없음. 이는 implicit regularization 현상의 존재를 나타냄.

- 연속적인 상태-행동 튜플의 features의 dot-products을 최대화하기 위한 implicit 선호를 "Feature co-adaptation"이라고 부름.

(4) When does feature co-adaptation emerge?

- Figure 1 (Right)의 상단 열에서 볼 수 있듯이, Offline SARSA의 feature dot products은 빠르게 수렴하고 비교적 안정적이며, 지도 회귀와 유사함.

- 이는 부트스트랩 업데이트만 사용하는 것이 features의 dot products 증가와 불안정성의 원인이 아니라는 것을 나타냄. 왜냐하면 Offline SARSA는 Bellman Backups을 사용하면서도 supervised regression의 결과와 유사하기 때문. 반면 시간차 학습을 통해 학습된 DQN인 Offline TD Learning에서는 feature co-adaptation이 나타남.

- Offline SARSA와 Offline TD Learning의 주요한 차이점은 a'의 출처임.

- Offline SARSA는 항상 학습 데이터 집합에서 관찰된 행동 a'를 학습에 사용함.

- 반면에 Offline TD-Learning은 학습 데이터 집합에서 본적 없는 행동 a'를 학습에 사용하며, 이는 데이터 생성 정책의 분포 내에 있음.

- 이것은 Bellman Backup에서 "out-of-sample" 행동을 활용하는 것이 out-of-distribution이 아닐지라도, learning dynamics을 중대하게 변경한다는 것을 시사함.

- 이것은 오프라인 강화학습에서 더 일반적으로 관찰되는 것과 구별됨. 이는 학습 과정의 어려움을 out-of-sample 행동의 관점으로 보는 것이 아니라, out-of-distribution 행동의 관점으로 돌리는 것임.

3.2. Theoretically Characterizing Implicit Regularization in TD-Learning

- 저는 이론 증명 과정에는 흥미가 없기 때문에 ㅋㅋ 결론만 정리하겠습니다.

(1) Theorem 3.1 (Implicit regularizer at TD fixed points)

- implicit regularizer for noisy GD in supervised learning : 지도학습에서의 implicit regularizer에 해당

- additional terim in TD learning : co-adaptation과 poor-representations을 유도하는 원인

(2) Why is implicit regularization detrimental to policy performance?

- 왜 implicit regularization이 정책 성능에 해로울까?

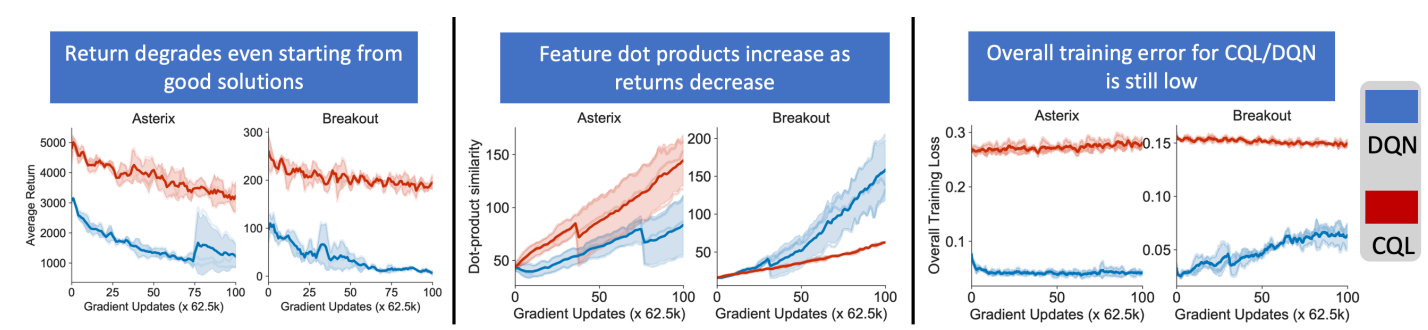

- implicit regularization이 부정적인 영향을 끼친다는 "경험적" 증거

- pre-train된 DQN과 CQL을 실험 모델로 사용함. 이때 pre-trained모델은 feature dot-product 값이 상대적으로 작음 (Figure 2의 중앙 그래프 참고)

- 이 실험의 목표는 이러한 "좋은" 초기 상태에서 시작하는 TD updates가 여전히 그 주변에 머무르거나, 더 나쁜 해결책으로 발산하는지 확인하는 것임.

- Figure 2의 왼쪽, 중앙 그래프에서 볼 수 있듯이, 정책의 성능(Average Return)이 즉시 악화되며, Dot-product similiarity가 증가하기 시작함. 심지어 Learned Policy와 Behavior Policy 사이의 distributional shift를 명시적으로 보정하는 CQL에서도 이러한 현상이 발생함.

- 이는 전형적인 out-of-distribution action 설명으로 직접적으로 설명할 수 없다는 것을 시사함.

- 이러한 성능 하락의 원인은 무엇일까? Figure 2의 오른쪽 그래프에서 볼 수 있듯이 CQL과 DQN 모두 손실 함수의 값은 일반적으로 작은 것을 볼 수 있음. 이는 feature dot product를 증가시키려는 선호가 TD error를 최소화하지 못함으로 설명되지 않는다는 것을 나타냄.

- 부록 A.7에서 DR3 regularizer를 사용했을 때, 이러한 성능 하락을 효과적으로 완화할 수 있음을 보여줌.

- 따라서 standard TD Learning 뿐만 아니라 좋은 해결책에서 feature dot prodcut를 늘리는 방향으로 성능이 저하되는 것을 발견했을 뿐만 아니라, 작은 feature dot product를 유지함으로써 이러한 알고리즘들의 학습 안정성이 유지되는 것을 발견함.

- implicit regularization이 부정적인 영향을 끼친다는 "이론적" 증거

- Proposition 3.2에 대한 증명은 부록 D에 소개되어 있음.

- Proposition 3.2는 co-adaptation의 결과로 인해 TD-Learning이 수렴하지 않을 수도 있다는 것을 나타남.

4. DR3 : Explicit Regularization for Deep TD-Learning

(1) DR3 개요

- TD Learning에서 implicit regularization 효과가 feature co-adaptation으로 이어질 수 있으며, 이는 결과적으로 성능 저화와 관련될 수 있음. 그래서 이 문제를 완화하기 위한 explicit regularizer를 어떻게 도출할 수 있을까?

- 이에 따라 Equation 4의 두번째 항을 상쇄하는 explict regularizer를 제안함. 이 두번째 항이 그대로 남아있으면 co-adaptation과 poor representations으로 이어질 것임.

- 2개의 implicit regularizer의 차이를 상쇄하는 explicit regularizer는 다음과 같이 주어짐. 이는 $R_{TD}(\theta)$의 두번째 term을 나타냄.

- DR3는 다양한 오프라인 강화학습 알고리즘과 결합될 수 있음. 이에 대한 학습 Objective는 다음과 같이 정의할 수 있음

- $L(\theta) := L_{A_{LG}}(\theta) + c_{0}\Delta(\theta)$

- $L_{A_{LG}}\left (\theta \right )$ : 오프라인 강화학습 알고리즘의 Objective

- $c_{0}$ : DR3 Term의 계수 (해당 값은 부록 E.3에 자세히 설명되어 있음)

(2) Practical version of DR3.

- DR3를 실제로 구현하기 위해서는 특정한 노이즈 모델 M을 선택해야 함.

- 일반적으로 M의 "올바른" 선택을 미리 알기는 어려움. 이는 데이터 분포의 복잡한 함수, 신경망 아키텍쳐 그리고 initialization 때문임.

- 따라서 DR3를 2개의 heuristic choices으로 구체화 함.

- 지도 학습에서 연구된 label noise로 인한 M을 선택. 이 M에 대한 계산적으로 무거운 fixed-point 연산이 필요함.

- $\sum^{*}_{M}=I$로 설정하는 더 간단한 대안을 선택.

- 위 2가지 변형이 기존 오프라인 강화학습보다 일반적으로 성능을 향상시킨다는 것을 발견함. 그런데 2번 방법의 계산 비용이 더 낮기에, 2번 방법의 노이즈 모델을 실제로 사용함.

- 또한, 각 변형의 gradient dot-product를 계산하고 역전파하는 것은 연산 속도가 느림. 이에 따라 $\delta(\theta)$를 계산할 때 마지막 레이어 매개변수에서의 contribution만 고려하는 근사치로 대신함. 실제 버전의 DR3는 label noise 버전과 유사하게 작동하며, 아래의 수식과 같음.

5. Experimental Evaluation of DR3

(1) 실험 개요

- 실험 목표

- DR3가 오프라인 강화학습에서 실제로 어떻게 성능을 향상시키는지 평가

- 기존의 rank collapse의 기존 관찰에 미치는 영향을 연구

- 실험 환경

- Atari 2600 게임 : 이산적인 행동 공간을 가짐

- D4RL : 연속적인 행동 공간을 가짐

- image-based robotic manipulation tasks

(2) Offline RL on Atari 2600 games

- 3 종류의 데이터셋에서 평가함

- DQN replay buffer에 있는 데이터 중 1%만 랜덤하게 샘플링한 데이터셋

- DQN replay buffer에 있는 데이터 중 5%만 랜덤하게 샘플링한 데이터셋

- online DQN에서 관찰된 처음 10% 샘플만 포함된 sub-optimal 데이터셋

- Tabel 1은 IQM(Interquartile mean) average performance를 기록함.

- 모든 데이터셋에 대해 DR3가 적용된 CQL, REM의 성능이 향상된 것을 볼 수 있음

- CQL+DR3는 최종 성능에서 CQL 대비 20% 향상되고, 평균 성능에서는 25% 더 나은 성능을 얻음

- Figure 4는 학습 동안의 17개의 게임에 대한 IQM normalized scores를 기록함.

- REM은 학습이 진행될수록 성능 저하가 보였지만, DR3가 이러한 성능 저하를 방지한 것을 볼 수 있음 (Figure 4의 top row)

- DR3는 "확실이 안정적인" 것은 아니지만, 기존의 오프라인 강화학습 알고리즘(CQL, REM)에 비해 상대적으로 더 안정적임.

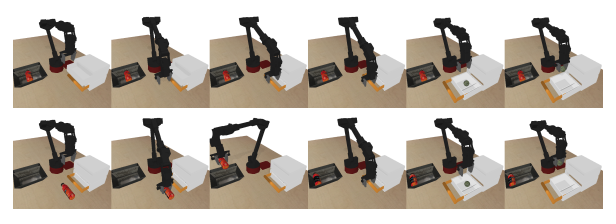

(3) Offline RL on robotic manipulation from images

- 해당 작업의 reward는 오직 sparse하게 0 또는 1을 제공함.

- Figure 3에서 볼 수 있듯이, COG+DR3의 성능이 COG보다 높음을 볼 수 있음.

(4) Offline RL on D4RL tasks

- DR3가 안정적이며 CQL에서 나타나는 최종적인 학습 손실을 방지할 수 있는지를 평가하기 위해, 해당 실험을 진행. 기존 실험은 학습 횟수를 1M만큼 진행했지만, 이 실험은 2M, 3M에 대한 학습을 진행.

- Table 2에서 볼 수 있듯이, 대부분의 상황에서 CQL+DR3의 성능이 우수함을 볼 수 있음.

(5) DR3 does not suffer from rank collapse

- DR3를 적용하면 rank collapse에 빠지지 않음을 볼 수 있음.

(6) Comparing explicit regularizers for different choices of noise covariance M

- CQL+DR3(label noise)와 CQL+DR3의 성능이 가장 좋음을 볼 수 있음. 이는 noise model을 $\sum^{*}_{M=I$로 설정하면 label noise에 비해 연산량은 줄면서 성능은 비슷한 것을 볼 수 있음.

(7) Discussion

- TD Learning의 implicit preference를 특징화 했음. 이는 Bellman Backup에서 나타나는 연속적인 상태-행동 쌍의 gradient(또는 features)를 최대한 co-adapt하려는 경향을 가지고 있음.

- 이러한 regularization 효과는 Bellman Backup에 out-of-sample을 사용할 때 악화되며, 정책 성능의 저하로 이어질 수 있음.

- 이에 따라 본 연구에서 실용적인 explicit regularizer DR3를 제안함. 이는 다양한 오프라인 강화학습 문제에서 학습 안정성과 최종 성능을 크게 향상시킴.

Appendices E. Experimental Details of Applying DR3

- 제가 관심있는 부분만 정리했습니다 ㅎㅎ

(E.1) Background on Various Offline RL Algorithms

- CQL : Conservative Q-Learning

- $\alpha$ 튜닝

- Atari Game : $\alpha$ = 0.1

- D4RL : $\alpha$ = 5.0

(E.2) Tasks and Environments Used

(E.3) The DR3 Regularizer Coefficient

- DR3가 적용된 오프라인 강화학습 모델의 Object Function : $L(\theta) := L_{A_{LG}}(\theta) + c_{0}\Delta(\theta)$

- 효과적인 c_0의 값을 찾아야 함!

- Atari 게임에서 사용한 계수 값 : {0.001, 0.01, 0.03, 0.3}

- REM에서는 0.001이 성능이 가장 좋았음

- CQL에서는 0.03이 성능이 가장 좋았음

- D4RL에서 사용한 계수 값 : {0.0001, 0.001, 0.01, 0.5, 1.0, 10.0}

- antmaze에서는 0.001이 성능이 가장 좋았음

- FrankaKitchen에서는 1.0이 성능이 가장 좋았음