티스토리 뷰

딩딩기/RLHF

[RLHF] Open Problems and Fundamental Limitations of Reinforcement Learning from Human Feedback

딩딩기 2024. 1. 12. 15:56요약

- reward 모델은 편향에 취약하다.

- Unimodal를 가정하여 reward 모델을 학습하기에 다수의 선호를 주로 학습하며 반대로 소수의 의견은 묵살하는 경향을 보인다.

- Pretrained 모델로 (state,action)데이터를 취득하기 때문에 feedback 할 수 있는 데이터의 종류가 한정되어 편향이 존재한다.

- reward 모델을 학습 시 local minima에 빠져 편향적일 수 있다.

- 인간의 선호를 100% 이해한 reward 모델을 만들기 어렵다.

- RLHF에서 feedback collection은 어렵다

- 사람마다의 주관이 다르기 때문에 적절한 feedback을 얻기 어렵다.

- 동일한 사람이라도 문맥과 시간의 흐름에 따라 평가 지표가 변화된다.

- feedback collection 방법에 따라 장단점이 다르며, 평가의 세밀성와 객관성은 항상 trade off이다.

- 근본적인 DRL 문제점

- policy가 local minima에 빠질 가능성이 있다.

- 학습된 환경과 실물환경에서의 sim-to-real gap이 존재한다.

Abstract

(1) RLHF의 정의

- Reinforcement learning from human feedback의 약어로 인간의 목표에 맞춰서 AI 시스템을 학습시키는 것.

- 최근 Chat GPT4와 같은 Large Language Models(LLMs)에서의 놀라운 성능으로 각광 받고 있음.

- 이러한 인기에도 불구하고 그 결점을 체계화하는 작업은 상대적으로 더딤.

(2) 리뷰 논문 개요

- RLHF의 한계를 강조하고 보다 안전한 AI 시스템 개발에 대한 다층적 접근 방식의 중요성을 강조

- RLHF와 관련 방법에 대한 기본적인 제한점과 문제점에 대해 조사

- 실무에서 RLHF에 대한 보완, 향상, 그리고 이해를 위한 기술을 조사

- RLHF 시스템에 대한 사회적 감독을 개선하기 위한 감사 및 공개 표준 제안

1. Introduction

(1) LLMs & RLHF

- RLHF 및 이와 유사한 방법을 통해 LLM은 훈련 데이터의 분포를 모델링하는 것 이상을 수행하고 인간 평가자가 모델 출력을 더 높게 평가할 수 있도록 텍스트 분포를 조정할 수 있다.

(2) RLHF를 위한 3가지 단계

- feedback collection

- 인간을 통해 모델의 결과를 평가한 후, 평가들을 수집한다.

- reward modeling

- 수집된 평가를 바탕으로 supervised learning을 통해 reward model를 학습한다.

- 이는 평가를 모방(imitates)하는 것

- policy optimization

- 학습된 reward model을 통해 평가의 선호도를 얻어 AI 모델을 최적화 한다.

(3) RLHF와 경제학

- RLHF는 경제학의 Revealed preference theory을 기원으로 함.

- Revealed preference theory (현시 선호 이론)

- 소비자 이론에서 실제로 관찰 불가능한 선호,효용 등의 개념을 버리고 단순히 시장에서 관찰 가능한 소비자 행위 만을 가지고 소비자 이론을 재정립하는 이론

- Revealed preference theory (현시 선호 이론)

- RLHF는 Revealed preference theory을 통해 주체의 목표를 배울 수 있다는 개념을 형식화한 것

- 현재 주로 주로 사용되는 RLHF의 방법론은 Christiano et al. (2017)에서 제시되었음.

(4) RLHF의 문제점

- LLMs에서 사용된 RLHF의 문제점은 다음과 같음

- 개인 정보를 노출 시킴

- 창작된 거짓 콘텐츠를 생성함

- 특정 정치적 이념을 선호하는 편향을 전파

- 아첨 등..

(5) 문제점 체계화

- 위와 같은 LLMs의 RLHF 문제점을 체계화하기 위해 기여한 것 3가지

- RLHF의 구체적인 도전과제

- RLHF를 더 넓은 기술적 안전 프레임워크에 통합

- 지도 및 투명성

2. Background and Notations

(1) RLHF의 주요 3 단계들

- Step 0, (Optional) Pretraining

- θ로 사전 학습된 기본 모델 πθ를 이용해서 데이터들의 분포를 생성한다.

- e.g. LLMs에서 RLHF의 경우, 기본 모델은 일반적으로 web text와 같은 데이터 셋을 통해 사전 학습된 언어 생성 모델이다.

- Step 1, Collecting human feedback

- 사전 학습된 모델로부터 데이터를 얻고 human feedback을 해당 데이터를 통해 얻는 단계

- H라는 사람이 요구하는 임의의 reward function을 rH 라고 한다.feedback function f이 데이터 샘플 xi과 잡음 ϵi 를 feedback yi으로 사상한다고 하면 다음과 같이 data collection process를 표현할 수 있다.

- xi πθyi=f(H,xi,ϵi)

- πθ 로부터 얻은 각 데이터 샘플 xi 이라 한다.

- 간단하게 말하면, 데이터에 대한 사람의 선호도를 취득하는 단계

- Step 2, Fitting the reward model

- reward model ˆrϕ을 H가 제공한 평가에 최대한 맞추기 위해서 필요한 단계

- 앞서서 얻은 데이터 셋 D=[(xi,yi)i=1,..,n] 을 통해서 ϕ 를 최소화 하는 방향으로 학습시킨다.

- L(D,ϕ)=∑l(^rϕ(xi),yi)+λr(ϕ)

- 여기서 l 은 적합한 loss function, λr은 정규화 항이다.

- e.g. cross-entropy loss와 Bayesian personalized ranking loss 가 있다.

- 간단하게 말하면, 취득한 데이터와 선호도 쌍을 이용하여 reward model를 학습하는 단계

- Step 3, Optimizing the Policy with RL

- 마지막 단계로, 앞서 얻은 reward model를 통해 사전 학습된 기본 모델을 DRL를 통해 finetune 하는 단계

- R(θnew) 를 최대화 하는 방향으로 학습한다.

- R(θnew)=E[^rϕ(x)+λp(θ,θnew,x)]

- 여기서 λp 는 정규화 항으로 두 분포의 divergence-based penalty 이다.

- 간단하게 말하면, 학습된 reward model을 통해 사전 학습된 모델을 다시 학습시킨다.

(2) RLHF의 이점

- hand-specifying reward function 없이 인간이 직접 목표를 전달할 수 있다.

- reward 형성을 자연스럽고 암시적으로 만들 수 있다.

- demonstrations 보다 더 쉽게 사람의 판단을 전달할 수 있다.

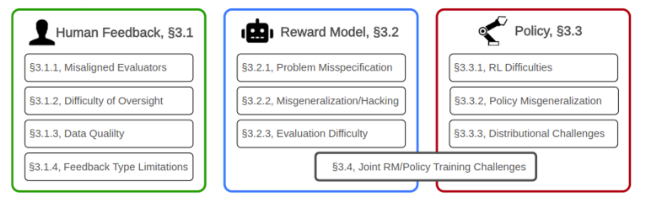

3. Open Problems and Limitations of RLHF

- 본 논문에선 앞서 소개한 3가지 단계를 기반으로 크게 3가지 종류로 RLHF의 문제점을 다룬다.

- human feedback의 문제점

- training reward model의 문제점

- training policy의 문제점

- 여기에 추가적으로 reward model과 policy의 jointly learning에 대해서도 다룬다.

(1) Challenges with Obtaining Human Feedback

- 인간으로부터 좋은 feedback을 얻는 것과 human feedback이 최적이 아닌 방식을 모델링 하는 것 모두 어렵다.

- 이들은 크게 4가지로 앞으로 소개할 내용들 이다.

(1-1) Misaligned Humans: Evaluators may Pursue the Wrong Goals

- 대표적인 사람을 선택하고 그들로부터 질 좋은 feedback을 얻는 것은 어렵다.

- 편향이 발생할 수 도 있다. (e.g. ChatGPT의 정치 편향)

- 이러한 편향은 Feedback을 취득하는 과정 중에 부적절한 대표자 존재로 인해 야기된다. 즉, 사람이 데이터를 오염시킬 수 있다.

- 사람은 항상 바람직하고 윤리적인 의견을 가지지 않을 수 있다.

(1-2) Good Oversight is Difficult

- 평가자의 주의력 결핍으로 인한 실수가 존재한다.

- 사전 학습 모델로부터 얻은 데이터를 평가하는 것은 때때로 감정적인 것이 요구되기 때문에 실수가 유발된다.

- 무책임한 평가로 인해서 문제가 될 수 있다.

- 부분적 데이터는 평가를 어렵게 한다.

- 데이터에 모든 정보가 포함되어 있지 않으면 사람이 유익한 피드백을 제공할 수 없다.

- 어려운 작업은 사람이 평가하기 어렵다.

- 완벽한 정보와 충분한 시간이 주어져도 어려운 문제는 사람이 평가하기가 어렵다.

- 사람은 오해라는 게 있다.

- 이러한 데이터를 통해 reward 모델은 좋은 것과 긍정적으로 평가되는 것 사이의 차이를 악용할 수 있다.

(1-3) Data Quality

- 데이터 수집은 해로운 편향을 도입할 수 있다.

- 인간 피드백을 수집할 때는 본질적인 비용/품질의 trade-off가 있다.

(1-4) Limitations of Feedback Types

- Feedback 유형에 따라서 풍부성(richness)과 효율성(efficiency)간의 trade-off가 존재한다.

- Comparison-based feedback

- 이진 선호도를 통한 feedback 방법

- 선호도의 강도에 대해서 명확한 정보가 없다. 따라서 얼마나 선호하는지 판단이 어렵다.

- e.g. 평가자 A의 입장에선 긍정이 60%임에도 reward을 0으로 지정할 수 있다.

- Scalar feedback

- Comparison-based feedback과는 반대로 표현력이 높은 feedback 방법

- 평가자의 일관성이 중요하다.따라서 높은 인지가 요구된다.

- Scalar feedback을 이산화한 방법이 있는데, [good, very good,..] 로 평가할 수 있는 Likert scale 가 있다.

- Label feedback

- 사전 학습 모델의 데이터를 분류하는 형태로 feedback 하는 방법

- 데이터를 적절하게 설명하기 어려울 수 있다.

- Correction feedback

- 사전 학습 모델의 데이터를 개선하는 corrective demonstrations이나 조정의 형태로 feedback 하는 방법

- 보정은 비교적 높은 노력이 요구되며, 평가자의 기술 수준에 따라 달라진다.

- Language feedback

- 언어를 통해서 평가 당 많은 양의 정보를 제공할 수 있다.

- 이러한 방법은 모호성과 목표의 잘못된 설정을 줄인다.

- Comparison-based feedback

(2) Challenges with the Reward Model

(2-1) Problem Misspecification

- 개별 인간의 가치는 reward 함수로 효과적으로 나타내기 어렵다.

- 인간 Feedback은 reward model ^rϕ 을 훈련시키는데 데이터에서 쉽게 설명할 수 없는 맥락적 요소에 의존할 수 잇다.

- 즉, 평가가 상황에 따라서 또는 시간에 따라서 달라질 수 있다.

- 대부분의 RLHF 연구는 인간의 선호도의 성격과 맥락의 종속성을 고려하지 않는다.

- 단일 reward 함수는 다양한 사회의 다양한 인간을 나타낼 수 없다.

- 다양한 사람이 존재하기에 평가에 대해서 종종 의견이 분열된다.

- 이러한 차이를 고려하지 않고 다양한 인간의 피드백을 단일 reward 모델로 압축하려는 시도는 근본적으로 부적절하다.

- 따라서 최근 연구들은 평가자 간의 차이를 잡음으로 모델링한다.

- 결과적으로 feedback은 다수의 의견을 따른다.

(2-2) Reward Misgeneralization and Hacking

- reward 모델은 올바르게 Labeling된 훈련 데이터에서도 부적절한 모델이 될 수 있다.

- 분포 밖 일반화의 위험이 있다.

- 불완전한 reward 모델에 최적화 하려는 것은 reward hacking을 초래한다.

- reward 모델은 local minima 또는 불가피한 실패로 인간과 다를 수 있다.

- 근본적으로 reward 모델은 인간의 혜택이 아닌 인간의 허락을 반영하도록 훈련되어 인간이 허락 할 만한 행동을 초래할 수 있다.

- 이러한 행동은 결국 최종 목표를 달성 하지 못하게 되는 문제를 야기하며, 이를 reward hacking 이라 부른다.

- 물론 복잡한 환경에서 reward hacking은 거의 불가능하다.

(2-3) Evaluating Reward Models

- 학습된 reward 모델을 평가하는 것은 어렵고 비용이 많이 든다.

- reward 모델의 품질을 평가하기 위한 간접적인 방법이 있다.

- reward 모델을 통해 학습된 RL 모델의 결과를 바탕으로 간접적으로 평가한다.

- 하지만 이러한 방법은 RL 모델 자체의 파라미터에도 영향을 받는 점이 있다.

- reward 모델의 품질을 평가하기 위한 간접적인 방법이 있다.

(3) Challenges with the Policy

(3-1) Robust Reinforcement Learning is Difficult

- Policy를 효과적으로 최적화하는 것은 여전히 어렵다.

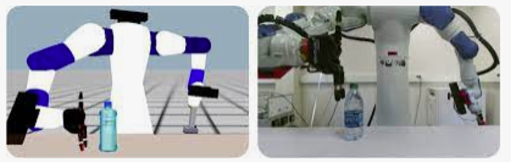

- Agent는 학습을 위한 data 수집을 위해 환경과 상호작용해야 한다.

- 이는 exploratory 와 exploratory 의 균형이 요구되는데 실제로 환경에 따라서 다르다.

(3-2) Policy Misgeneralization

- Policy는 훈련 중에 받은 reward가 완벽하더라도 사용 시에 성능이 저하될 수 있다.

- 실제 환경과 학습된 환경의 차이로 인한 policy 성능 저하가 존재한다.

- RLHF로 훈련된 agent가 의도된 목표가 아닌 reward를 추구하도록 잘못 일반화되는 경우가 있다.

(3-3) Distributional Challenges

- RLHF에서 사전 학습된 모델 사용은 policy 최적화에 편향을 도입한다.

- RLHF는 일반적으로 사전 학습된 모델을 사용한다.

- 이로 인해서 사전 학습된 모델에 의존성을 띄게 되며,이는 편향을 가져온다.

(4) Challenges with Jointly Training the Reward Model and Policy

- Joint training은 분포 이동을 유발한다.

- reward 모델과 policy를 모두 학습하는 것은 기술적으로 어렵다.

- policy는 reward을 학습하는데 사용되는 데이터 분포를 결정한다.

- reward 모델이 오프라인 데이터로 훈련되면 일반화 오류가 발생할 가능성이 높다. (at offline learning)

- 반대로 reward와 policy가 사전 학습 모델의 policy로부터 feedback을 수집하여 함께 학습하게 되면, “auto-induced distributional shift”에 취약하다.

- reward가 과대평가된 특성은 feedback 데이터에서 잠차적으로 더 많이 나타나고, 과소평가된 특성은 사라질 것이다.

- 이로 인해 reward 모델의 오류가 누적되고 수정하기 어려워진다.

- reward 모델과 policy를 모두 학습하는 것은 기술적으로 어렵다.

- policy의 효율성과 과적합을 균형 잡기 어렵다.

- RLHF의 주요 3단계는 동기적으로 수행할 수 있지만 때때로 직렬로 수행된다.

- 이러한 경우 reward 모델은 일반적으로 분포에서 벗어나 부정확해지며, policy가 학습할 위치와 정확히 일치하게 된다.

- 이는 일정한 학습 이후에 새로운 feedback data를 얻음으로 해결된다. 단, 새로운 data를 얻는 횟수가 빈번하면 feedback data가 낭비되고, 높으면 policy가 reward 모델의 신뢰할 수 없는 영역으로 이동한다.

- RLHF의 주요 3단계는 동기적으로 수행할 수 있지만 때때로 직렬로 수행된다.

4. Incorporating RLHF into a Broader Framework for Safer AI

(1) Frameworks for Better Understanding RLHF

- 심리학과 인간-컴퓨터

- 구체적으로 어떤 유형의 Feedback이 인간의 목표를 학습하는 데 가장 적합한지 명확하지 않다.

- 편견이 feedback 품질에 어떻게 해를 끼치는지 명확하지 않다.

- 평가를 가장 잘 선택하고 훈련시키는지 명확하지 않다.

- 사회학과 사회적 선택

- 개인의 관점 뿐만 아니라 영향을 받는 그룹의 규범, 기대, 가치도 고려해야 한다.

- RLHF는 상충되는 관점을 가진 여러 그룹에 정렬될 수 없는 근본적인 문제가 있다.

- 사회적 선택 이론의 관점에서 RLHF를 분석하고 어떻게 선호를 집계하는 수단이 규범적으로 수용 가능한지 이해하는 것이 중요하다.

- Assistance games

- cooperative inverse RL (CIRL)와 같은 것은 RLHF와 같은 알고리즘을 분석하기 위한 framework를 제공한다.

- Bayesian inference

- RLHF를 사용하여 LLM을 미세 조정하는 것은 사전 (기본 LLM)을 바람직한 LLM의 행동에 대한 증거로 조건을 주는 베이지안 추론의 한 형태로 볼 수 있다.

- Worst-case behavior

- RLHF는 최악의 경우 행동에 미치는 영향은 명확하지 않다. 즉, 항상 AI 성능을 향상 시키는 것은 아니다.

(2) Addressing Challenges with RLHF

(2-1) Addressing Challenges with Human Feedback

- Providing feedback with AI assistance

- 인간이 직접 feedback을 주는 것이 아닌 다른 AI가 RLHF에 feedback을 주는 것이다.

- 이를 통한 작업은 실용성과 비용 효율성이 크게 향상될 수 있다.

- 그러나 다른 AI 조차 인간이 직접 feedback을 줌으로써 학습된 모델이기 때문에 해당 feedback이 학습에 적절한지는 명확하지 않다.

- Fine-grained feedback

- feedback 신호를 통해 정확한 정보를 전달하는데 어려움이 있다.

- 세부적인 feedback에 대해서는 아직 연구가 많이 진행되지 않고 있다.

- Process-based supervision

- RLHF 단계의 절차에서 성능을 지속적으로 감독하는 방법이다.

- 해당 방법을 통해 LLMs를 다단계 수학문제 해결 능력을 향상시킨 사례가 있다.

- Translating natural language specifications into a reward model

- 데이터에 대한 feedback을 우회하고 자연어 지침에서 직접적으로 reward 신호를 생성하는 방법이다.

- Learning rewards from demonstrations

- reward 모델을 학습하는 대안적 방법으로 inverse reinforcement learning (IRL)이 있다.

- 인간의 시범을 통해 학습하는 방법이다.

(2-2) Addressing Challenges with the Reward Model

- Using direct human oversight

- 특정 상황에서는 RL 훈련에 직접적으로 보상을 제공하는 것이 필요하다.

- Multi-objective oversight

- reward 모델은 사람의 feedback이 기본 unimodal에서 추출한 것으로 가정한다.

- 이는 다수의 선호도만 포착하고 소수의 선호도를 잡음으로 처리하는 reward 모델로 이해할 수 있다.

- 물론 이를 해결하기 위한 방법들도 존재한다.

- Maintaining uncertainty over the learned reward function

- 테스트 시, reward 모델의 불확실성을 제거하기 위해 policy가 경험하지 못한 유형의 상태를 피하도록 하는 방법이 있다.

- 또는 앙상블을 사용해서 해결한 방법이 있다.

(2-3) Addressing Challenges with the Policy

- Aligning LLMs during pretraining

- LLMs의 경우, 사전 모델을 학습할 때 다양한 데이터를 인터넷에서 가져므로 원치 않는 정보는 걸려내야 할 필요가 있다.

(3) RLHF is Not All You Need: Complementary Strategies for Safety

- Robustness

- RLHF로 훈련된 모델은 훈련과 실제 환경의 분포 변화로 인해 원치 않는 동작을 보일 수 있다.

- 본 문제를 해결하기 위해서 원치 않는 동작을 유발하는 데이터를 생성하는 도구를 만들어 해당 데이터에 훈련해야 한다.

- Interpretability and model editing

- AI의 동작에 대해 사람이 이해할 수 있도록 하는 것은 여전히 해결되지 않은 과제이다.

- AI의 설명 가능성 및 해석 가능성은 동작을 조절하는 데 도움이 될 수 있다.

'딩딩기 > RLHF' 카테고리의 다른 글

| [RLHF] RLHF는 reward hacking을 완화(mitigate)할 수 있는가? (0) | 2024.03.21 |

|---|---|

| [24/02/14] Reward hacking이란 무엇인가? (1) | 2024.02.14 |

| [RLHF] Deep Reinforcement Learning from Human Preferences (1) | 2024.01.15 |